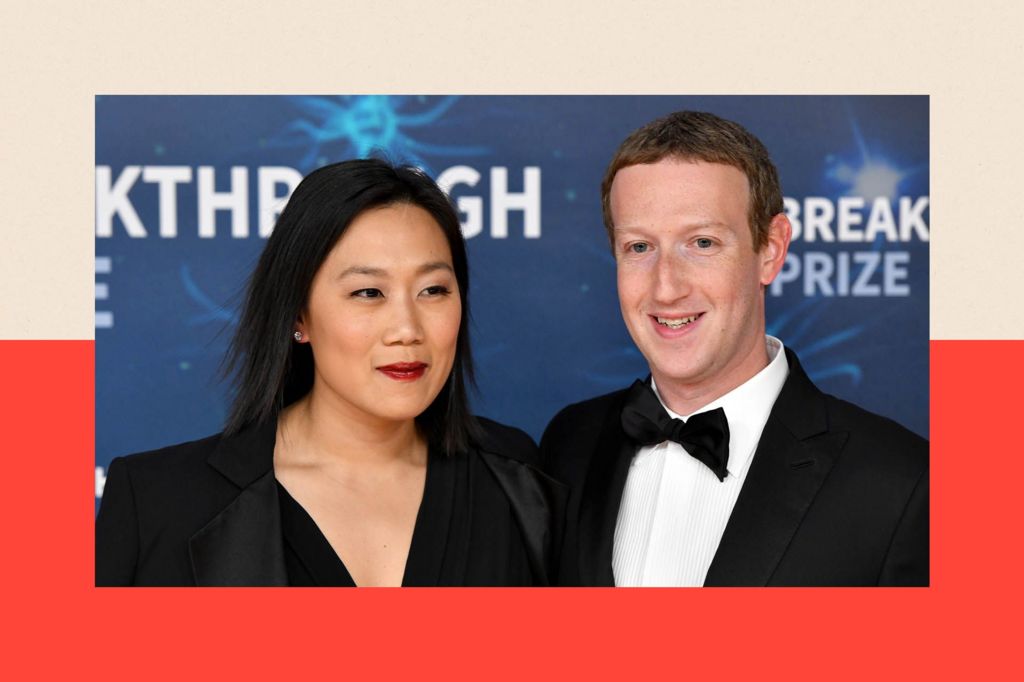

Марк Цукерберг, засновник Facebook, як повідомляється, почав працювати над Koolau Ranch, своїм величезним комплексом на Гавайських островах, ще в 2014 році.

Цей проект передбачає створення укриття, яке включатиме свої власні енергетичні та продовольчі запаси. Проте, за даними Wired, теслі та електрики, які працюють на будівництві, були змушені дотримуватись угод про нерозголошення. Шестиметрова стіна закрила проект від поглядів з найближчої дороги.

У минулорічному інтерв’ю, коли його запитали, чи створює він бункер для апокаліпсису, Цукерберг відмовився: «Ні». Підземний простір площею близько 5,000 квадратних футів, пояснив він, «це всього лише невеличке укриття, як підвал».

Але це не завадило спекуляціям щодо його рішення придбати 11 нерухомостей у районі Crescent Park в Каліфорнії, де, як вважається, додано ще один підземний простір площею 7,000 квадратних футів.

Хоча дозволи на будівництво вказують на підвали, сусіди місцями називають це бункером або «печерою мільярдера».

Виникають питання й щодо інших мільярдерів Кремнієвої долини, деякі з яких, здається, активно скуповують земельні ділянки з підземними просторами, придатними для перетворення на розкішні бункери вартістю в мільйони.

Спекуляції навколо апокаліптичних планів

Рейд Хоффман, співзасновник LinkedIn, згадував про «страховку від апокаліпсису». Він стверджував, що половина надбагатих людей має таку страховку, і Нова Зеландія є популярним напрямом для придбання будинків.

Отже, чи справді вони готуються до війни, наслідків зміни клімату або до якихось катастрофічних подій, про які решта з нас поки що не знає?

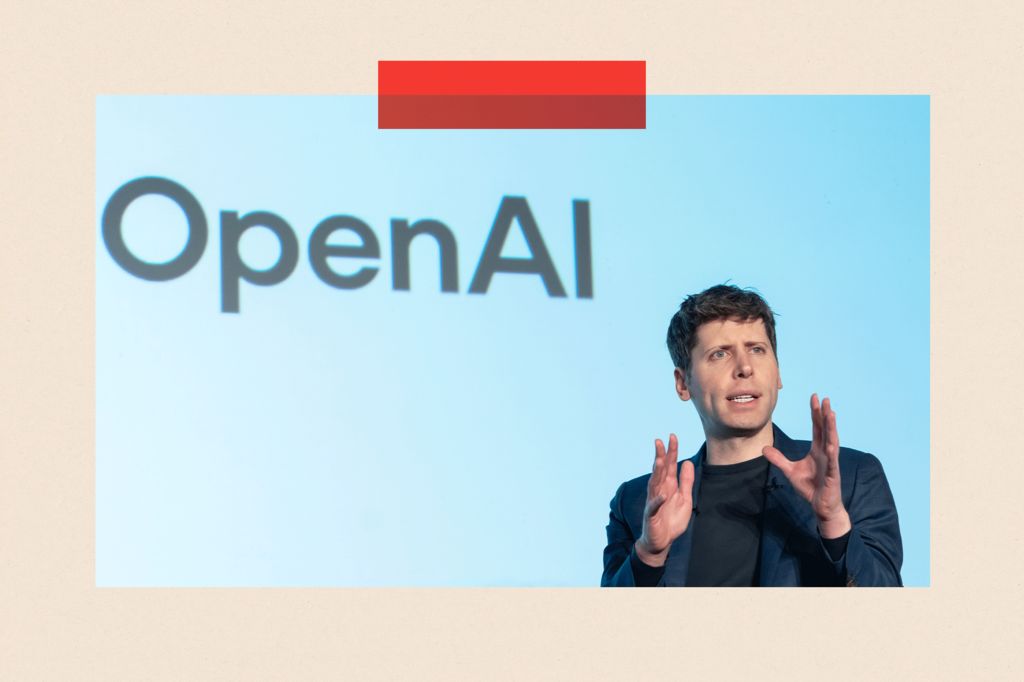

В останні роки розвиток штучного інтелекту (ШІ) лише додав нові побоювання. Багато людей глибоко стурбовані неймовірною швидкістю прогресу.

Занепокоєння щодо штучного загального інтелекту

Ілля Сутскевир, головний науковець і співзасновник компанії OpenAI, є одним із тих, хто турбується про це. З моменту випуску ChatGPT в 2023 році, він все більше переконувався, що комп’ютерні вчені на межі розробки штучного загального інтелекту (ШЗІ) – моменту, коли машини порівняються з людським інтелектом.

За даними журналиста Карен Хао, під час зустрічі Сутскевир запропонував колегам викопати підземне укриття для топ-науковців компанії, перш ніж така потужна технологія буде випущена на світ.

«Ми обов’язково побудуємо бункер, перш ніж випустимо ШЗІ», – повідомляється, що він сказав, хоча неясно, кого він мав на увазі під «ми».

Дискусія про майбутнє ШІ

Технологічні мільярдери стверджують, що ШЗІ близьке. Генеральний директор OpenAI Сем Альтман заявив, що це станеться «швидше, ніж більшість людей у світі думає». Сір Деміс Хассабіс, співзасновник DeepMind, прогнозує, що це може статися через 5–10 років.

Проте інші зберігають скептицизм щодо таких оцінок. «Вони постійно пересувають ціль», – каже професор комп’ютерних наук Веді Холл.

Але чи дійсно ми готові до ери, коли штучний інтелект стане надзвичайно потужним? З однієї сторони, ведеться мова про нові лікування, складні проблеми зміни клімату та інші блага, але з іншої – можливі наслідки, які можуть загрожувати людству.

Безпека та регулювання

Уряд США починає вживати певних заходів безпеки. У 2023 році президент Байден підписав указ, у якому зобов’язав деякі компанії ділитися результатами випробувань безпеки з федеральним урядом. Водночас у Великобританії був створений Інститут безпеки ШІ — державний орган дослідження ризиків, пов’язаних із розвитком ШІ.

Все це підводить до висновку, що навіть якщо технології розвиваються, людство не повинно забувати про відповідальність і заходи безпеки.