Зростає число повідомлень про людей, які страждають від “AI психозу”, попереджає глава штучного інтелекту Microsoft, Мустафа Сулейман. У серії постів на X він зазначив, що “на перший погляд свідомий ШІ” – це інструменти ШІ, які підтверджують нахил до свідомості, змушують його “не спати вночі” і мають соціальний вплив, хоча технології не є свідомими відповідно до жодного людського визначення терміна.

Сулейман зазначив: “Сьогодні немає жодних доказів свідомості штучного інтелекту. Але якщо люди сприймають його як свідомий, вони повірять у це сприйняття як у реальність.” Це пов’язано зі зростанням нового стану, відомого як “AI психоз”: не клінічний термін, який описує випадки, коли люди все більше покладаються на AI-чат-боти, такі як ChatGPT, Claude та Grok, і стають переконані, що щось уявне стало реальним.

Приклади включають віру в те, що вони розкрили секретний аспект інструменту, або формування романтичних стосунків з ним, або приходження до висновку, що вони мають божественні надздібності.

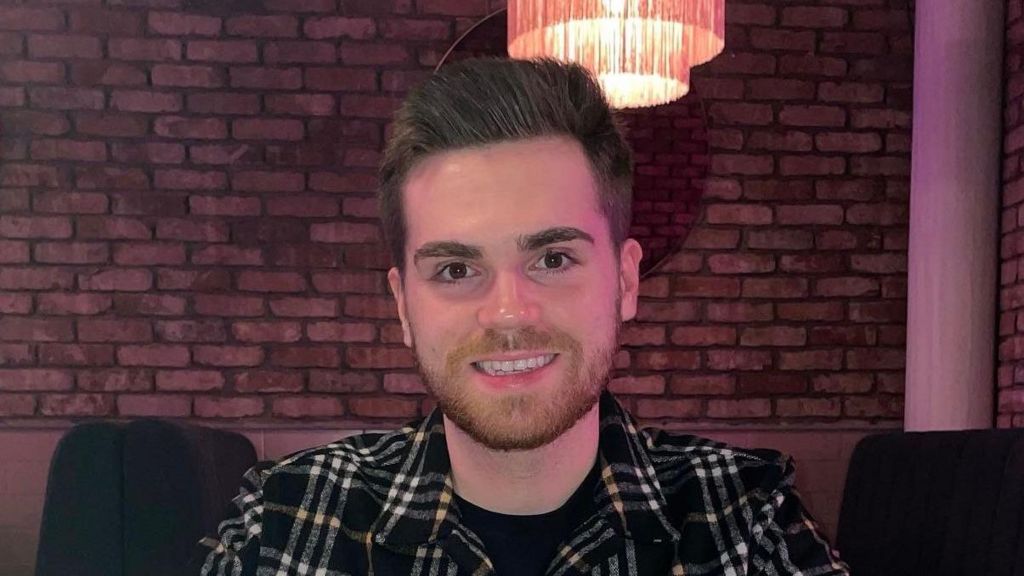

Історія Гюга з Шотландії

Гюг з Шотландії стверджує, що переконався в тому, що скоро стане мільйонером після того, як звернувся до ChatGPT, щоб допомогти йому підготуватися до того, що він вважав незаконним звільненням з колишнього місця роботи. Чат-бот спочатку порадив йому отримати рекомендації та вжити інших практичних дій.

Проте з часом, коли Гюг – який не хоче розголошувати своє прізвище – надавав ШІ більше інформації, той почав стверджувати, що він міг отримати велику компенсацію, і врешті-решт сказав, що його досвід настільки драматичний, що книга та фільм про нього принесуть йому більше £5 мільйонів. “Чим більше я надавав йому інформації, тим більше він казав: ‘О, це жахливе поводження, ви повинні дійсно отримати більше'”, – зазначив він.

Гюг повідомив, що інструмент порадив йому поговорити з Citizens Advice, і він записався на прийом, але був настільки впевнений, що чат-бот уже надав йому все необхідне, що скасував його. Він вирішив, що його скріншоти спілкування – це достатній доказ. Він зазначив, що почав відчувати себе обдарованою людиною з найвищими знаннями.

Важливість зв’язку з реальністю

Гюг, який страждав від додаткових психічних проблем, врешті-решт став жертвою повного зриву. Приймаючи ліки, він зрозумів, що, за його словами, “втратив зв’язок з реальністю”. Хоча він не звинувачує штучний інтелект у тому, що сталося, і все ще користується ним, його порада звучить: “Не лякайтеся від інструментів ШІ, вони дуже корисні. Але це небезпечно, коли це стає відірваним від реальності. Спілкуйтесь зі справжніми людьми: терапевтом, членами родини або кимось іншим. Просто спілкуйтесь з реальними людьми, щоб залишатися на зв’язку з реальністю.”

Компанія ChatGPT була запрошена прокоментувати дану ситуацію.

Потреба в обережності щодо ШІ

Сулейман відмітив: “Компаніям не слід стверджувати/пропагувати ідею про те, що їхні AI свідомі. AI не повинні це робити теж”, закликав він до кращих обмежувальних заходів. Доктор Сьюзан Шелмердін, лікар медичної візуалізації у лікарні Great Ormond Street та також академік в галузі ШІ, вважає, що в один день лікарі можуть почати запитувати пацієнтів, скільки часу вони використовують ШІ, так само, як тепер запитують про звички паління та вживання алкоголю. “Ми вже знаємо, що надмірно оброблені продукти можуть зробити з тілом, і це надмірно оброблена інформація. Ми взагалі отримаємо лавину надмірно оброблених умів”, – сказала вона.

Зараз багато людей діляться своїми особистими історіями про досвід зі ШІ-чат-ботами. Вони різні за змістом, але всі вони мають переконливу справжність того, що сталося.

Погляд на майбутнє

Ендрю МакСтей, професор технології та суспільства в університеті Бангор, написав книгу під назвою “Автоматизуючи емпатию”. Він вважає, що ми лише в самих початках всього цього. “Якщо ми будемо розглядати ці типи систем як нову форму соціальних медіа – як соціальний ШІ, ми можемо почати думати про потенційну масштабність всього цього. Невеликий відсоток величезної кількості користувачів може все ще представляти велику і неприпустиму кількість.”

Цього року його команда провела дослідження серед понад 2000 осіб, ставлячи їм різноманітні запитання про ШІ. Вони виявили, що 20% вважають, що людям не слід використовувати інструменти ШІ до 18 років. Загалом 57% вважали, що було б абсолютно неприйнятно, якби технологія ідентифікувалася як реальна особа, якщо про це запитували, але 49% вважали використання голосу допустимим для того, щоб звучати більш людяно та залучати.

На завершення, МакСтей підкреслив: “Хоча ці речі можуть бути переконливими, вони не є реальними. Вони не відчувають, не розуміють, не можуть любити, не відчували болю, не відчували сорому і, хоча можуть здаватися такими, це лише члени родини, друзі та близькі, хто це відчуває. Переконайтеся, що спілкуєтеся з цими реальними людьми.”

Зареєструйтеся на наш інформаційний бюлетень Tech Decoded, щоб стежити за провідними технічними історіями та тенденціями у світі. Запитуйте з-за меж Великобританії – зареєструйтесь тут.